Как найти и удалить дубликаты фотографий

Разгребал фотографии со смартфонов, сделанных за все время (с 2004 года). Раскладывал их по папкам по годам. Чтобы избежать потери фотографий, так как там было немало файлов с совпадающими именами, копировал с переименованием. В результате получил кучу дублей. Разгребать их вручную, конечно, было бы глупо, поэтому стал искать программку, которая бы сделал это за меня.

Пара бесплатных вариантов с задачей не справились: одна программа была с дичайшим интерфейсом и пользоваться ею было невозможно, другая была поприличнее, но поиск среди почти 8000 файлов ее в прямом смысле слова убивал - вываливалась.

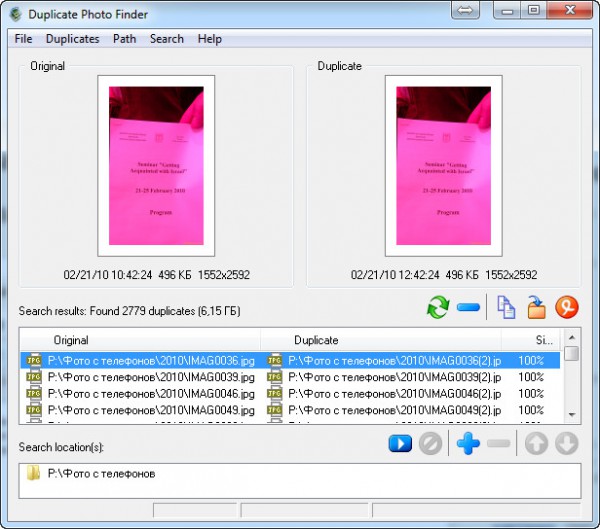

Пошел по платным. Первый вариант (триальная версия) тоже был очень и очень кривой. А вот второй вариант погонял в триале - и в результате купил. Это Duplicate Photo Finder. Она у меня нашла порядка 3000 дублей из 8000. Причем там обработка удобная - можно проверить каждый дубль, скопировать дубли в отдельную папку, переместить дубли в отдельную папку, удалить дубли. Ну и, в общем, на поиск и удаление 3000 дублей я затратил своего времени где-то пару минут. Красота.

Если кто-то знает хорошие бесплатные варианты - поделитесь в комментариях, плиз, наверняка кому-то пригодится.

В качестве бонуса поделюсь программкой WinDirStat windirstat.info которая позволяет быстро увидеть куда делось место на дисках

Но тут уже столько рабочих вариантов накидали, что Пикаса, наверное, нафиг не нужна 😄

Для случая на сриншоте подходит Total Commander: Alt+F7 - Advanced - Find duplicate files (same size).

Не подходит. Может удалить разные файлы, одинаковые по размеру.

Alex Exler: Если кто-то знает хорошие бесплатные варианты - поделитесь в комментариях

Вроде в посте предельно ясно все сказано, но что только не предлагают. И платные, и программы для поиска любых дубликатов (хотя это можно даже в тотал командере делать).

Да, без проблем ищет в 27 Гб фотографий.

ImageDupeless

Он давно не развивается и обладает весьма убогим интерфейсом, но дубликаты ищет хорошо, имеет кучу настроек для разных вариантов отбора. Когда-то перебрал множество вариантов и остановился именно на этом. А из бесплатных не понравился ни один.

Это какого размера должен быть жесткий диск, что бы разбить его на столько разделов? ну С,Д, ну Е, но Р?

Это не показатель количества разделов. У меня и Z есть. Букву-то руками можно задать.

М - movies T - torrents и т.п.

(а P - наверное photos)

Мож там где то глубина мутного глаза регулируется , я не нашел 😄

Жаль программа сто лет не обновлялась, да и фирма похоже уже загнулась.

сто лет пользуюсь. все супер. гибкий настраиваемый алгоритм посика дублей. бесплатная!

Пока что не нашёл ничего лучшего чем :

www.al-soft.com

Но платная...

Прекрасно справляется с 200-300 тисячами файлов. Устанавливаеш проверять hash (самый малый обём - 10кб) и поехали - ну очень шустро делает дело.

А про всякие "similar" ищейки вобще помолчу - алгоритмы у них настолько удивительние что иногда непоймёш почему она видит попугая и носорога как близнецов 😄

Когда-то пользовался этой - analinx.com/products/duplicatch/duplicatch_setup.exe

Умеет делать нечеткое сравнение 😄

find -not -empty -type f -printf "%s\n" | sort -rn | uniq -d | xargs -I{} -n1 find -type f -size {}c -print0 | xargs -0 md5sum | sort | uniq -w32 --all-repeated=separate

Сначала находятся файлы одинакового размера, потом из них отбираются те, которые имеют одинаковый MD5-хэш. Итоговый список выводится в консоль.

Отсюда

Правда, находятся только полностью, байт-в-байт, идентичные файлы.

А вообще вот есть список искалок .

У нее есть такая функция, но на подобных количествах она дико тупила.

PS Опоздал 😄