Ура, ура, это новое слово в науке и технике, изобретена целая лаборатория на коже!

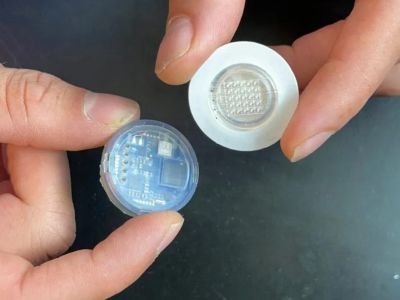

Исследователи из Центра носимых датчиков Калифорнийского университета в Сан-Диего разработали устройство, которое непрерывно и в режиме реального времени может неинвазивным способом отслеживать уровень глюкозы, алкоголя и лактата в организме человека.

Устройство крепится к коже с помощью микроскопических игл, похожих на липучку, каждая из которых составляет всего 20% от толщины человеческого волоса. Микроиглы обнаруживают в поверхностных слоях кожи биомолекулы в интерстициальной жидкости, после чего данные передаются по беспроводной сети в пользовательское приложение на смартфон. Помимо мониторинга глюкозы, необходимого для пациентов с диабетом, оно также может оценивать уровень алкоголя — его повышение влияет на значение глюкозы в крови, — а отслеживание количества лактата укажет на мышечную усталость (физическая активность тоже влияет на этот показатель).

«Это похоже на целую лабораторию, размещённую на коже. Устройство способно непрерывно измерять несколько биомаркеров одновременно, позволяя пользователям следить за своим здоровьем и самочувствием во время повседневной деятельности», — рассказал директор центра Джозеф Ван, профессор наноинженерии в Калифорнийском университете в Сан-Диего.

Следующие шаги в коммерциализации устройства включают тестирование и улучшение того, как долго пластырь с микроиглами может прослужить до замены. Компания также воодушевлена возможностью добавления дополнительных датчиков для контроля уровня лекарств у пациентов и других показателей организма.

Интересно, а этим прекрасным людям кто-нибудь расскажет, что термин неинвазивный означает именно то, что в организм не происходит никаких проникновений? Которое здесь, что совершенно очевидно, происходит - микроскопические иглы прокалывают кожу. И что даже если "они совсем на полшишечки" и "вы ничего не почувствуете" - это все равно ИНВАЗИВНЫЙ способ получения результатов.

Кроме того, пока не очень понятно, чего тут такого революционного. Подобные датчики постоянного мониторинга глюкозы существуют уже как минимум пять-семь лет. Самый известный из них - FreeStyle Libre, причем он работает именно по такому принципу: на руку крепится небольшой кругляшок, который погружает под кожу нитевидный сенсор, после чего ведется постоянный мониторинг, результаты которого поступают в соответствующее приложение на смартфоне.

Также существуют и другие аналогичные системы мониторинга, действующие по похожему принципу.

Поэтому как-то не очень понятно, что они там такого изобрели. Ну, разве что заодно еще и уровень алкоголя измеряют, но вряд ли его вообще нужно мониторить в постоянном режиме.

На только что прошедшей конференции Google I/O компания представила новый режим для карт Google. Это называется "иммерсивный вид" (immersive view), и данный режим по сути представляет собой совершенно новый уровень панорам улиц. Если раньше это просто была нарезка снимков улиц, сделанных гугл-мобилями, то теперь для формирования иммерсивных панорам также используются аэрофотоснимки, обработанные искусственным интеллектом.

Также объявлено, что в эти панорамы будет интегрироваться информация об автомобильном трафике, то есть мы сможем визуально отслеживать загруженность улиц и исходя из этого планировать свои маршруты. Выглядеть это будет как-то так.

Вот в этой статье приводят всякие подробности - "Visiting a new city? Check the 'vibe' first! Google Maps challenges Apple's 3D mode with new 'immersive view' that lets you virtually explore neighbourhoods".

Пишут, что в сравнении с аналогичным режимом, который есть в Apple Maps, здесь все выглядит заметно более реалистично, потому что Google использует намного больше данных от спутников.

Также обещается, что для многих строений будет доступен и просмотр внутренних помещений, которые моделируются на основе имеющихся фотографий.

Появление данного режима обещают к концу года. Первоначально он будет доступен в Лос-Анджелесе, Лондоне, Нью-Йорке, Сан-Франциско и Токио, после чего "в ближайшее время" будут появляться и другие города.

В нынешней ситуации, когда происходящее просто не укладывается в голове, многие люди находятся в постоянном затяжном стрессе. Однако нужно хорошо понимать, что если вы будете в буквальном смысле слова "сжигать" себе нервы с утра до вечера, то ничему и никому это не поможет, а вам и вашим близким от этого будет только хуже.

Нужно как-то уметь продолжать жить в подобных стрессовых ситуациях, нужно учиться как-то себя контролировать, нужно учиться как-то пытаться отрешиться от ужаса происходящего и сосредоточиться на решении всевозможных чисто практических вещей.

Поэтому ради бога - не сидите с утра до вечера в куче новостных лент, где рассказывается о войне. Уверяю вас, самые плохие новости вы совершенно точно не пропустите. А сидеть и непрестанно ловить новости - худшее, что можно придумать. Нужно как-то отвлекаться и заниматься чем-то другим.

В издании Daily Reminder - полезная статья на эту тему, цитирую:

Экстремальный затяжной стресс — тяжелое испытание для психики. В случае одномоментного травматического события мы можем переработать его последствия задним числом. А при длительном кризисе непосредственное переживание и переработка травмы происходят одновременно. В такой ситуации особенно важна психологическая устойчивость. Вот несколько простых способов ее укрепить.

• Соблюдайте рутину. Исследования показывают, что элементарное поддержание распорядка дня (подъем в одно и то же время, утренние ритуалы и т.д.) помогает сохранить психологическую устойчивость. Во-первых, это дает возможность структурировать день и таким образом ослабить ощущение неопределенности, которое вызывает приступы тревоги или депрессии. Во-вторых — снижает усталость от принятия мелких решений.

• Верните самоконтроль. Если вы испытываете беспомощность — сделайте что-нибудь. Этот метод помог психологу Бруно Беттельгейму выжить в концлагере. Из-за постоянного внешнего прессинга и запретов заключенные быстро ломались. Беттельгейм нашел выход: делать все, что не запрещено, когда хочешь. Если есть возможность лечь спать — ложись. Можешь почистить зубы — чисти. Главное — психологически вернуть себе власть над происходящим. «Когда появляется личное пространство, вам становится легче на всех уровнях, потому что вы больше не чувствуете себя заложником ситуации», — говорит Пола Дэвис-Лаак, основательница Института стресса и жизнестойкости.

• Восстановите ощущение собственной значимости. Первое, что страдает от травмы, — чувство собственного достоинства. Мы начинаем казаться себе ничтожными и беспомощными. Чтобы восстановиться, можно использовать технику дерефлексии, разработанную еще одним известным психологом и узником концлагеря — Виктором Франклом. Мысленно переключитесь с неразрешимой проблемы на те вопросы, которые вы можете решить. Франкл приводит в пример историю человека, который потерял жену и считал, что теперь его жизнь бессмысленна. Стоило ему представить, как страдала бы его жена, если бы он умер первым, он сразу испытал облегчение и почувствовал, что в его страданиях есть смысл.

• Найдите того, кому хуже, и помогите ему. Есть такое понятие — «эйфория помощника»: когда вы помогаете ближним, мозг вырабатывает эндорфины, вознаграждая вас за хороший поступок эмоциональным подъемом.

• Замечайте хорошее. Да, это трудно. «Но быть пессимистом проще всего», — замечает герой романа Йена Макьюэна «Ореховая скорлупа». Негативный опыт фиксируется в сознании глубже, чем позитивный, объясняет психолог Элисон Леджервуд. Чтобы видеть положительные стороны жизни, нужно в буквальном смысле прилагать больше усилий. Возьмите за правило делиться с друзьями и близкими не худшими, а лучшими впечатлениями дня. Это не значит зарывать голову в песок. Так вы психологически поддержите их и себя.

• Стройте планы на будущее. Прогнозы программируют поведение. На короткой дистанции для сохранения жизнейстойкости нам нужны сомнения и готовность к неудачам. В долгосрочной перспективе — ясная цель впереди и твердая уверенность в позитивном результате. Планы не обязательно должны быть детальными и конкретными. Достаточно просто знать, что вас ожидает какое-то важное дело впереди. Как говорил известный американский психиатр Персиваль Бейли: «Чтобы выжить, надо все время ставить перед собой новые задачи».

Со всех сторон приходят новости о том, что, мол, Google создал нейросеть, способную заменить программистов. Вот одна из заметок подобного рода.

Холдинг Alphabet, созданный основателями Google, разработал особую нейросеть, способную самостоятельно писать программный код и превращать его в работающие программы. Как пишет The Verge, над нейросетью, получившей название AlphaCode, работали специалисты компании DeepMind, входящей в холдинг.

Разработчики уверены, что в перспективе AlphaCode сможет заменить собой далеко не только начинающих программистов, чьи навыки в кодинге пока далеки от совершенства. Эта нейросеть может лишить работы и программистов более высокого уровня – со слов авторов AlphaCode, она уже «ничем не хуже среднего программиста».

Другими словами, на текущий момент работу в случае широкого распространения AlphaCode сохранят лишь самые опытные и талантливые программисты. Однако нейросети имеют свойство обучаться, и нет гарантии, что со временем она не заменит и их. Вероятность такого исхода подтверждает и тот факт, что в настоящее время AlphaCode находится на ранней стадии разработки, о чем The Verge сообщил Ориол Виньялс (Oriol Vinyals), главный научный сотрудник DeepMind.

А вот очень интересный комментарий Сергея Аксенова по этому поводу - цитирую из его Facebook.

Во-первых, Google заменил не программиста, а участника олимпиады по программированию. Разница в точности как между драг-рейсером и водителем такси или тракером-дальнобойщиком) Во-вторых не среднего, а медианного, это тоже разные вещи, хоть и не настолько.

Теперь почему все программисты завтра или через 10 лет не останутся без работы. Олимпиадное программирование - это максимально быстрое достижение очень жёстко поставленной цели. Победителя определяет скорость работы программы, но это не главное, главное - что для того, чтобы все участники были в равных условиях - олимпиадные задачи снабжаются широким набором тестов: программ, проверяющих, что конкурсные программы действительно делают то, что написано в задаче.

И вот эти тесты "стоят" в человеко-часах намного больше, чем само решение. Применить такой подход в коммерческой разработки ПО - всё равно что, возвращаясь к аналогии с гонщиками, расставить через каждую 1/4 мили ампайров с клетчатыми флагами, оборудование для фотофиниша, стартовые светофоры, а также перекрыть всё движение на время проведения заезда по всему городу (для таксистов) или по всей трассе (для дальнобойщиков). Уверен, что при таких вводных автономные такси и фуры уже давно бороздили бы всё, что подобным образом оборудовано.

Тем не менее у этой истории есть несколько векторов развития.

Первое. В разработке ПО есть такая дисциплина, как формальная верификация. Это способ математически доказать, что вот эта вот программа действительно делает ровно то, что она должна делать. Это очень дорогой процесс, он стоит в разы больше, чем разработка самого ПО, и поэтому применяется в системах типа космических аппаратов, атомных станций и т.п., где цена ошибки пропорционально высока. Одним из применений AlphaCode может быть как раз переписывание уже формально верифицированного ПО, с целью его оптимизации. Критерии оптимизации могут быть разными - размер программы (если надо её уместить в более дешёвый процессор), скорость выполнения (если нужна более оперативная реакция) и т.д. Но даже до этого нам скорее всего не один год.

Второе. Также есть такая штука, как автоматизированное тестирование ПО: когда часть функционала программы проверяется другой программой на адекватность. Практически все хорошие программы сегодня имеют ту или иную степень покрытия автотестами. Но это не является формальной верификацией, потому что автотесты покрывают только некоторые типичные и краевые случаи применения, а не вообще все; стало быть и написать по автотестам код нейросеть не сможет.

Есть, однако, такая штука, как fuzzy testing, когда на вход автотесту подаются всегда разные случайные значения, а тест на основе этих значений может понять, правильный ли ответ дала программа. На базе таких тестов AlphaGo возможно сможет сотворить что-то представляющее интерес. Давайте понаблюдаем, как оно там будет развиваться.

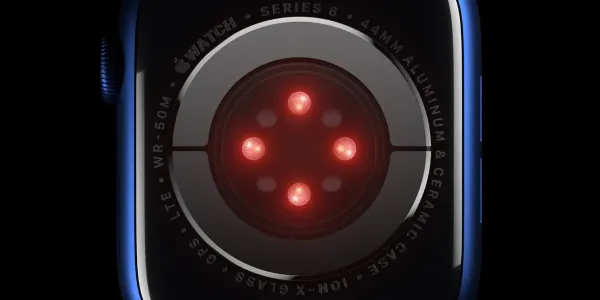

Интересная и познавательная статья в Deep-Review - "Биоимпедансный анализ для «чайников». Как смарт-часы и весы научились определять состав тела?".

Подробно о том, что это за метод, как он работает, каким образом получается информация, можно ли ей доверять, какие при этом могут быть погрешности и что влияет на точность измерения.

Ну и заключение из статьи, кому не хочется со всем этим разбираться (а оно интересно).

В завершение хочу сказать следующее. Биоимпедансный анализ из-за всех озвученных ограничений, не является точным методом. Тем не менее, относиться к этому инструменту как к игрушке тоже неправильно.

Практически невозможен такой вариант, чтобы денситометрия (золотой стандарт) показала 29% жира, а смарт-часы или умные весы — 19%. Биоимпеданс достаточно точен для удовлетворения любопытства. И тот факт, что даже смарт-часы с такой высокой корреляцией показывают состав тела, не может не радовать.

Эти устройства прекрасно подходят для того, чтобы следить за своим состоянием в динамике. Главное — правильно проводить измерение. Делать это утром в одно и то же время, после утреннего туалета, до того, как вы выпьете стакан воды.

Если речь идет о смарт-часах, нужно обязательно приподнимать руки во время измерения (лучше держать их перед собой), чтобы они не соприкасались с туловищем, особенно в области подмышек.

Также необходимо исключить любые металлические предметы на руках, включая металлический браслет, если вы используете часы именно с браслетом. Ну и, конечно же, пальцы правой руки должны касаться только кнопок-электродов. А сам контакт с кнопками должен быть уверенным и плотным.

Еще лучше избегать движений мышц во время измерения, чтобы возникающий в мышцах ток не вносил искажений.

Все мы помним волны народного возмущения, которые охватили США в знак протеста против кончины величайшего гуманиста Джорджа Флойда. Возмущенные граждане разбивали витрины магазинов и вовсю их грабили, чтобы таким образом потушить в себе пламя негодования: ворованные шмотки и гаджеты помогали им успокоиться. Разумеется, все эти граждане были уверены, что грабежи им сойдут с рук, ведь это же был благородный протест, а не какой-то там гоп-стоп, правильно?

Однако над некоторыми такими гражданами, громившими магазины Amazon Go в Сиэтле, пролетела птичка Обломинго, цитирую:

Reddit-пользователь опубликовал новость, в которой сообщил, что грабители магазинов Amazon Go в Сиэтле столкнулись с неожиданной ситуацией, в которой совсем не собирались оказаться. В их адрес пришли счета за украденные ими товары из магазинов Amazon Go. В частности, «письма счастья» получили грабители в Сиэтле.

Reddit-пользователь u/krui24 сообщает, что такая ситуация возникла вокруг как минимум одного магазина Amazon Go в Сиэтле. Эта торговая точка подверглась нападению со стороны демонстрантов, участвовавших в протестах «Black Lives Matter» из-за убийства полицией Джорджа Флойда. В сообщении Reddit утверждается, что протестующие подвергли магазин Amazon Go разграблению и забрали из него несколько предметов. Но оказалось, что установленная в магазине система автоматического сканирования оказалась умней, чем предполагали грабители.

Напомним, что компания Amazon, крупнейший в США онлайн- и розничный ритейлер, открыла свои первые магазины, работающие в формате «без кассы», еще в декабре 2016 года. Концепция магазина достаточно проста: при входе в магазин покупателям требуется отсканировать штрих-код в приложении на своем смартфоне. После прохождения аутентификации, можно свободно перемещаться по магазину и выбирать любой понравившийся товар на полках. Его можно забрать с собой, не платя на выходе. На выходе просто нет кассы, как нет и продавцов в торговом зале.

«Секрет» технологии состоит в том, что внутренняя система контроля отслеживает покупателя в торговом зале магазина Amazon Go. Она контролирует его перемещения и выставляет счет за снятые с полки товары. В результате нет необходимости в получении кассового чека или оплаты через кассу - счет автоматически выставляется прямо через банк. В настоящее время Amazon Go имеет 21 магазин в четырех городах США: Нью-Йорке, Чикаго, Сан-Франциско и Сиэтле.

В чем состоял прокол грабителей? Они посчитали себя неуязвимыми, не просканировав штрих-код со своего телефона на входе в магазин. Они просто ворвались в торговый зал и ограбили магазин. Но они были идентифицированы автоматически по включенному телефону. В результате грабителям, как сообщает Reddit-пользователь, был выставлен счет за предметы, которые они украли.

Новость уже распространилась по США. Многие уже высказывают мнение, что этого не может быть, потому что прямых доказательств нет. Они могут возникнуть, если грабители обратятся в суд за ошибочно выставленные им счета. Но пока грабители не воспользовались такой возможностью, которую предоставляет им закон.

Сообщается, что ранее Amazon не анонсировала, что ее система контроля в магазинах Amazon Go позволяет автоматически идентифицировать входящих в магазин, даже если им удалось обойти процедуру сканирования штрих-кода на входе. Но с точки зрения технической возможности такая реализация не вызывает сомнений.

Я считаю, что этим людям нужно обращаться в суд, чтобы защитить свое право на грабежи из благородных побуждений. Пепел Джорджа Флойда стучал в их сердце, ну и как можно при этом бездушно выставлять счета за украденные товары, как? Ведь это бесчеловечно!

Пост по поводу интересной технологии снижения частоты развертки у дисплея, которую Xiaomi применила в модели Xiaomi 12 Pro, я убрал: оказывается, подобная технология уже применялась в iPhone 13 (Pro), цитирую:

Как известно, старшие модели линейки iPhone 13 поддерживают переменную кадровую частоту дисплея. В зависимости от условий частота может изменяться в пределах от 10 до 120 Гц.

iPhone 13 Pro и 13 Pro Max получили уникальную функцию изменения кадровой частоты экрана в зависимости от активности пользователяОднако сейчас обнаружилась ещё одна любопытная деталь. Оказывается, частота может меняться не только в зависимости от приложения или нагрузки на смартфон. В iPhone 13 Pro и 13 Pro Max есть функция, меняющая кадровую частоту дисплея в зависимости от того, насколько быстро палец пользователя скользит по экрану.

К примеру, если пользователь открыл приложение Twitter и читает какое-то сообщение, кадровая частота снизится до 10 Гц. Если пользователь начнёт медленно пролистывать информацию, частота увеличится до определённого предела. К примеру, до 60 Гц. Если же начать листать активнее, частота поднимется до 90 или 120 Гц.

Благодаря такой функции смартфоны Apple могут эффективнее экономить энергию. И мы уже видели, что многочисленные тесты демонстрируют отличную автономность новинок. Правда, не будем забывать и о существенно увеличенных аккумуляторах.

Интересная, подробная, очень толковая и полезная для понимания сути механизмов измерения статья "Где мои смарт-часы с глюкометром!? Или почему трекеры до сих пор не измеряют уровень сахара в крови".

Речь в ней, конечно, идет далеко не только о трекерах или умных часах. Речь идет о неинвазивном способе измерения уровня глюкозы как таковом. И там очень подробно рассказывают, какие в настоящий момент способы существуют, в чем их проблемы, какова демонстрируемая точность и так далее. А то уже несколько лет подряд со всех сторон только и слышишь о том, что, мол, "скоро в часах Apple появится механизм измерения сахара", "Huawei выпустит часы с измерением уровня сахара" и так далее, причем для людей, которые за данной историей следят, все это выглядит очень нереалистичными обещаниями.

В статье, кстати, упоминаются CGM-системы или Continuous Glucose Monitoring (непрерывный мониторинг глюкозы), которые многие почему-то считают неинвазивными глюкометрами. Но они, во-первых, инвазивные, во-вторых, дорогие, в-третьих, быстро теряют точность и требуют замены каждую неделю - в общем, с ними проблем также хватает.

Ну и в конце статьи делается следующий важный вывод, цитирую:

Объем статьи не позволяет рассмотреть все методы неинвазивного измерения сахара, включая фотоакустический эффект (возникновение звука при облучении глюкозы светом), биоимпедансный анализ (метод, используемый также для определения состава тела в умных весах) и др.

Но, надеюсь, я смог донести основные мысли, которые еще раз повторю тезисно:

- Каждому человеку нужно знать уровень сахара в крови хотя бы для того, чтобы убедиться в отсутствии сахарного диабета, особенно 2-го типа, умеющего неплохо скрываться;

- Измерение глюкозы при помощи смарт-часов — не совсем безумная идея. В теории есть масса способов сделать это без крови и прокалывания кожи;

- На текущий момент нет ни единого доступного в продаже сертифицированного неинвазивного глюкометра в виде часов или браслета.

Появятся ли в этом году смарт-часы с глюкометром? Не знаю. Но могу с уверенностью сказать, что они не заменят «классический» глюкометр с тест-полосками еще лет 10 точно.

В статье мы затронули основные проблемы, которые нужно преодолеть, чтобы выпустить на рынок не очередную игрушку, а полезный инструмент. И пока этого сделать никто не смог, несмотря на миллионы долларов, которые готовы отдавать инвесторы любому желающему попробовать свои силы.

Сегодня многие пользователи жалуются на то, что их фитнес-трекеры неправильно определяют пульс или уровень кислорода в крови. Так если даже с такими примитивными задачами (а это именно примитивная задача по сравнению с измерением глюкозы) не всегда справляются трекеры, то о каком измерении сахара может вообще идти речь?

Многие неинвазивные технологии уже показывают неплохую (и даже очень хорошую) точность работы, если глюкозы в крови много (скажем, от 10-15 ммоль/л и выше). Но как только её уровень снижается, всё буквально разваливается. И это та стена, об которую бьются десятилетиями лучшие умы человечества.

В любом случае, надеюсь, теперь, когда вы хорошо представляете проблему, вам будет интереснее наблюдать за рынком. И когда первая компания выпустит свои смарт-часы с глюкометром, вы уже будете понимать принцип его работы и те трудности, которые пришлось преодолеть.

Ну и замечу, что автор совершенно прав еще и в том, что он говорит о необходимости мониторинга уровня сахара в крови, даже если вы считаете, что у вас никакого диабета нет - и в особенности, если вы боитесь, что у вас этот диабет уже есть.

Диабет - штука такая: чем раньше его обнаружить и начать этим серьезно заниматься, тем большего количества проблем и ограничений можно будет избежать впоследствии. Я сам с диабетом второго типа проходил года полтора, имея уже налицо все признаки (сухость во рту, постоянная жажда, потом еще и началась быстрая потеря веса на фоне ожирения) и обнаружили у меня его случайно, когда меня отправили на общий анализ крови по совершенно другому поводу (повод, впрочем, как раз начавшимся диабетом и был вызван, только я этого тогда не знал).

И у меня есть несколько знакомых с большим лишним весом (прямо-таки скажем - с ожирением), которые сознательно не измеряли у себя сахар, боясь обнаружить диабет (подход очевидно очень глупый и реально опасный). Один из них доходился до гипергликемической комы, от которой его, к счастью, откачали, но посадили на всю жизнь на инсулин, двое других доходились до осложнений, после чего им пришлось всем этим заниматься, но осложнения когда наступают, там фарш уже крайне сложно провернуть назад, можно только затормозить развитие.

Поэтому проверять, проверять, проверять и проверять! Купить глюкометр домой, чтобы время от времени измерять сахар у членов всей семьи (там в комплекте идет несколько иголок для прокалывания, можно каждому члену семьи выделить свою) - это стоит копейки (обычный глюкометр стоит менее 2 тысяч рублей; вот тест-полоски к нему недешевые, но если не нужно измерять по несколько раз в день, как это делают диабетики в определенных ситуациях, тогда это никак не проблема).

Обидно, да? 20 лет успешно скрывался в чужой стране, 10 лет не звонил на родину в Сицилию, и из-за какого-то Google Street View...

Джоаккино Гаммино, приговоренный к пожизненному заключению за убийство и внесенный в список самых разыскиваемых гангстеров Италии, был арестован в Галапагаре, городке недалеко от Мадрида, где он десятки лет жил под именем Мануэль, работал шеф-поваром и владел магазином фруктов и овощей. Его нашли только потому, что камеры сервиса Google Street View сделали снимок двух мужчин, болтающих у магазина под названием "El Huerto de Manu" ("Сад Ману") в Галапагаре.

Полиция посчитала, что один из мужчин очень похож на Гаммино, а позже его личность была подтверждена, когда следователи наткнулись на его фотографию на странице ресторана под названием" La Cocina de Manu" ("Кухня Ману") в "Фейсбуке".

На снимке Гаммино одет как шеф-повар, узнать его помог шрам на левой стороне подбородка. В меню ресторана входило блюдо под названием "Cena Siciliana", что переводится как "Сицилийский ужин".

Гаммино принадлежал к мафиозному клану в сицилийском городе Агридженто, который в 1990-х годах был вовлечен в кровавую вражду с "Коза Ностра", главной мафиозной сетью Сицилии. Впервые он был арестован в 1984 году, а второй раз его арестовали в Барселоне в 1998-м. Гаммино обвинили в убийстве и других преступлениях, связанных с мафиозной деятельностью, и приговорили к пожизненному заключению, которое он отбывал в римской тюрьме Ребиббия. (читать дальше)

Boston Dynamics не устает поражать.

Короткометражный (07:43) фильм с демонстрацией возможностей технологии Unity’s High Definition Rendering Pipeline. Впечатлило, да. Выглядит поразительно реалистично.

Вчера в комментариях к записи "Испания осталась без газа" обсуждали использование солнечной энергии. И мне на почту прислали статью руководителя компании "Битрикс" Сергея Рыжикова (я с ним лично знаком) "Солнечная электростанция на западе России", в которой он рассказывает о своем опыте установки электростанции в частном доме в городе Калининграде.

Вступление в статье такое.

Сегодня исполняется год как я сделал солнечную электростанцию, научился обеспечивать себя электричеством и даже научился отдавать излишки в городскую электросеть, и официально крутить счетчик в обратную сторону. Поговаривают, что я первый в стране частный дом, который делится излишками энергии с соседями.

Ну и далее в статье Сергей расписывает все этапы создания солнечной энергоустановки в его дома. Почитать было очень интересно.

Также, конечно, очень интересовали прикидки Сергея по поводу рентабельности подобной установки. Там выводы следующие.

Меня неоднократно спрашивали, окупится ли когда-то мой проект или нет. Я думаю, что именно мой проект полностью не окупится никогда. Он сделан не для экономии. Ну и я местами сильно перезаложился от нехватки опыта. Хотя, по старому курсу покупки и в условиях подключения к городу, у него есть шанс окупиться за 10 лет.

Солнечные батареи рассчитаны на десятилетия. Потеря эффективности с возрастом незначительная. Надо только не забывать их протират, я делаю это раз в год. На все оборудование гарантия так же лет десять. Аккумуляторы я научился экономно использовать благодаря подключению к городу.

Я уверен, что можно сделать экономически рентабельное подключение, особенно если скидывать энергию в город. Панели и инвертор, вот и все что нужно. 5-7 лет будет вполне достижимый цикл окупаемости.

Возможно в будущем появятся более эффективные солнечные пластины или более надежные аккумуляторы. Я так же уверен, что появятся готовые наборы для перевода дома на солнечную энергетику и можно будет осуществить такой проект и значительно дешевле и значительно быстрее.

Источник (англ.)

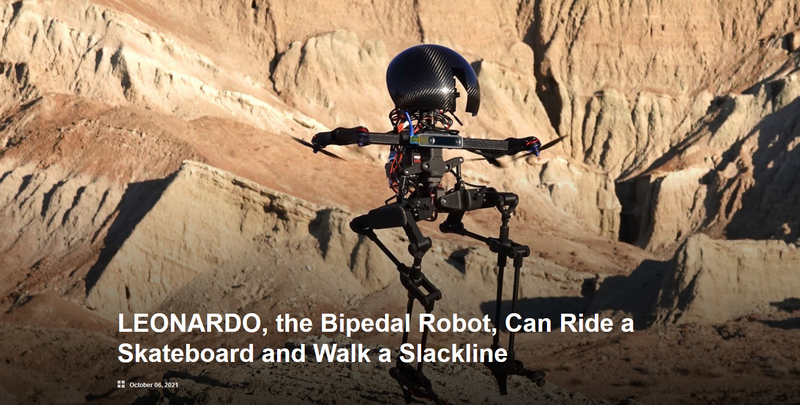

Исследователи из Калифорнийского технологического института создали двуногого робота, который сочетает ходьбу с полетом, что делает его исключительно проворным и способным к сложным движениям.

Назвали его LEONARDO (сокращенно от «LEgs ONboARD drOne» или сокращенно LEO) может ходить по натянутой веревке, прыгать и даже кататься на скейтборде. Разработанный командой Центра автономных систем и технологий (CAST) Калифорнийского технологического института, LEO является первым роботом, который использует многосуставные опоры и двигатели на основе пропеллера для достижения точной степени контроля над балансом.

«Мы черпали вдохновение в природе. Подумайте о том, как птицы могут хлопать крыльями и прыгать, чтобы перемещаться по телефонным линиям», - говорит Сун-Джо Чанг, автор-корреспондент и профессор Брена по аэрокосмическим и динамическим системам. «Птицы умеют совмещать ходьбу с полетом, этим мы и вдохновлялись при создании нашего робота».

Ну и, в общем, создатели намерены и дальше совершенствовать этого робота, потому что на данный момент энергия у него используется не слишком эффективно.

Но он уже производит впечатление, посмотрите ролик.

Зацените Тома Круза.

@deeptomcruise Sports!

♬ original sound - Tom

@deeptomcruise ♬ original sound - Tom

@deeptomcruise I love magic!

♬ original sound - Tom

Так вот, это не Том Круз. Это аккаунт Deeptomcruise, то есть работает технология DeepFake. При этом уже настолько качественная, что подделку не смогли распознать даже специальные алгоритмы, направленные на выявление фейков.

Я читал, что это аккаунт Майлза Фишера - имитатора Тома Круза: Майлз на него сильно похож. А сами дипфейки - работы специалиста по визуальным эффектам Криса Юме.

В общем, похоже, что сейчас фейк от реальности отличить уже почти невозможно: на роликах выше не видно никаких следов наложения даже во всяких сложных сценах (обычно все-таки DeepFake можно было отличить).

И не только глюкометре. Речь идет об датчике, способном измерять такие параметры, как внутренняя температура тела, артериальное давление, гидратация тела, уровни алкоголя, лактата и глюкозы. Так, по крайней мере, заявляет производитель.

Кратко.

Компания Rockley Photonics, ведущая мировая компания в области кремниевой фотоники, представила полную комплексную цифровую сенсорную систему "клиника на запястье".

Сенсорный модуль Rockley позволят носимым устройствам отслеживать несколько биомаркеров, включая внутреннюю температуру тела, артериальное давление, гидратацию тела, тенденции алкоголя, лактата и глюкозы, среди прочего.

Полнофункциональное сенсорное решение Rockley включает браслет, который содержит модуль датчика и взаимодействует с настраиваемыми облачными аналитическими механизмами через приложение для смартфонов Rockley. В ближайшие месяцы браслет будет использоваться в обследованиях людей.

Центральным элементом сенсорной системы является неинвазивный сенсорный модуль, основанный на спектроскопической технологии платформы Rockley. В отличие от более распространенных решений для спектроскопии, в которых используются источники света с широким спектром, сенсорный модуль Rockley генерирует большое количество дискретных выходных сигналов лазера от одного кремниевого чипа, охватывающего широкий оптический диапазон. Датчик неинвазивно исследует под кожей для анализа крови, межклеточных жидкостей и различных слоев кожи на предмет определенных компонентов и физических явлений, из чего потом делаются выводы. Ранее такие биомаркеры можно было измерить только с помощью настольного оборудования.

Ну, звучит-то это все очень интересно, но, как обычно, нужно смотреть на то, как это все будет выглядеть на практике. А то слухи-то о подобных устройствах идут давно, но воз и ныне там.

Также теперь понятно, откуда растут уши слухов о том, что новые часы Apple смогут определять уровень глюкозы в крови. Дело в том, что Apple - крупнейший клиент Rockley Photonics и имеет с компанией соглашение об использовании их разработок в своих носимых устройствах. Да и в Rockley Photonics заявляли, что их датчики могут быть установлены в умных часах уже в следующем году, так что вполне возможно, что эта технология появится в какой-то новой модели Apple Watch (например, в Apple Watch 8).

Ну, посмотрим. Все это очень интересно.

Яндекс таки запустил сервис автоматического закадрового перевода англоязычных видео в Youtube и Vimeo.

Пользователям "Яндекс.Браузера" и в мобильных приложениях стал доступен закадровый перевод видео с английского языка. Поддерживаются как мужской, так и женский голос, сообщается в пресс-релизе "Яндекса".

Перевод происходит в несколько этапов. Сначала ИИ распознает речь, превращает ее в текст и с помощью нейросетей разбивает на предложения. Потом определяет пол говорящего, переводит предложения на русский язык и синтезирует голос. Остается совместить перевод с видеорядом. Это совсем не тривиальная задача, потому что в русском языке предложения длиннее, чем в английском. Здесь на помощь снова приходят нейросети.

Поэтому процесс перевода занимает несколько минут - для этого нужно поставить видео на паузу и подождать. Как только все будет готово, пользователю придет соответствующее уведомление.

Согласно заявлению компании, поддерживаются любые англоязычные видео на YouTube, Vimeo и других популярных платформах. Перевод доступен в "Яндекс.Браузере" для Windows, macOS, Linux и Android и в мобильном приложении для Android и iOS. (Отсюда.)

В Яндекс.Браузере при просмотре англоязычных роликов на соответствующем сервисе появляется вот такая надпись.

Если нажать на кнопку включить, то может сразу пойти автоматический перевод, а может появиться вот такая надпись, и тогда придется подождать, прежде чем перевод будет готов.

Погонял разные ролики. Вообще очень прикольно и прямо-таки впечатляет. Понятно, что лучше всего включать перевод на сольных выступлениях, ну и понятно, что там будет немало всяких огрехов (это совершенно неудивительно), но в общем и целом понять смысл того, о чем говорится - вполне можно. И это круто!

Заметно хуже, когда разговаривают несколько людей и еще друг друга перебивают, но и с таким вариантом сервис более или менее справился.

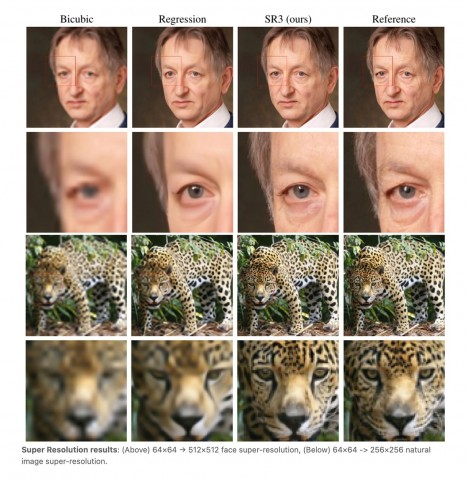

Я неоднократно читал о различных технологиях улучшения изображений и вообще за этими разработками стараюсь следить - это очень важно и будет востребовано.

Сейчас корпорация Google объявила о создании новой технологии улучшения изображения, повышающей разрешение картинки аж в 16 раз. Цитирую отсюда.

Разработчики Google представили новую технологию, благодаря которой можно значительно улучшить качество исходного изображения. Искусственный интеллект попиксельно восстанавливает даже сильно сжатую картинку, приближая её к оригиналу.

Команда Brain Team продемонстрировала два алгоритма генерации фотографий. Используя технологию SR3, предусматривающую апскейлинг с помощью повторного уточнения, нейросеть увеличивает разрешение картинки, достраивая недостающие части из гауссовского шума. Обучение этой модели построено на методах искажения изображения и последующем обратном процессе.

Вторая диффузная модель — CDM. Для её обучения специалисты использовали миллионы изображений в высоком разрешении из базы данных ImageNet. Улучшение качества картинки она производит каскадно — в несколько этапов. Так, исходник размером 32х32 пикселя улучшается до 64x64, а затем до 256x256 (в 8 раз), а оригинальное изображение с разрешением 64x64 точки обрабатывается по схожей схеме до 256x256 и 1024x1024 пикселя (масштабирование 16x).

По заверению разработчиков, новая технология превосходит по качеству восстановления фотографий такие современные методы ИИ-масштабирования, как BigGAN-deep и VQ-VAE-2.

На сегодня Google лишь продемонстрировала результаты работы алгоритмов посредством коротких анимаций, но ещё не публиковала подробностей о новой технологии. Когда компания планирует представить коммерческий вариант ИИ-апскейлера, не уточняется.

Выглядит это все очень интересно, но, как обычно, буду ждать, когда предоставят готовый инструмент, с помощью которого я смогу посмотреть, как это работает вживую.

Ну что, это круто, если все так и есть. Жду, когда появится - сравню с aptX HD, AAC и LDAC. Интересно, это вообще можно будет услышать? А то без хорошо прогретой бескислородной меди толком-то и не поймешь!

Qualcomm представила свою новую разработку — кодек aptX Lossless. По заверению компании, его использование обеспечит сторонникам Bluetooth-акустики качество аудио, сопоставимое с прослушиванием CD при классическом проводном подключении.

Представители Qualcomm подчёркивают, что при использовании гаджетов, которые получат поддержку кодека aptX Lossless, их владельцы смогут рассчитывать на значение битрейта до 1,4 Мбит/с. Поскольку пропускная способность самого Bluetooth-канала технически составляет 1 Мбит/с, компании пришлось применить специальную технологию потокового сжатия.

Впрочем, эксперты отмечают, что специально продуманные алгоритмы не приводят к ухудшению качества дорожки. Звук на входе идентичен выходному сигналу — 16 бит / 44,1 кГц (CD-качество). Новый кодек будет входить в состав технологии Snapdragon Sound, представленной в начале весны 2021 года.

Пока что ни одна из выпущенных Qualcomm мобильных платформ не поддерживает новую технологию. Ожидается, что выход на рынок первых смартфонов, совместимых со Snapdragon Sound и aptX Lossless, состоится уже в следующем году. (Отсюда.)

У замечательного Вастрика поразительно интересная (как обычно) статья о машинном переводе: о том, как это все начиналось, как развивалось, что с этим происходит сейчас, какие в этой области существуют прорывы и в чем заключаются проблемы. Кого интересует эта тема - очень рекомендую почитать: Вастрик, как обычно, прочитал кучу различных материалов, чтобы потом изложить все последовательно и понятно. Плюс - он реально хорошо и остроумно пишет, так что читать его - одно удовольствие. Цитировать ничего не буду, там просто нужно читать.

Кстати, должен заметить, что с появлением искусственного интеллекта машинный перевод стал заметно более продвинутым и видно, что это все активно развивается. Если раньше на перевод чего-то чуть более сложного, чем самая простейшая фраза, без слез смотреть было невозможно, то сейчас уже уровень машинного перевода заметно повысился. И машинные переводчики стали неплохо справляться даже со всякими непростыми временами, насколько я могу судить.

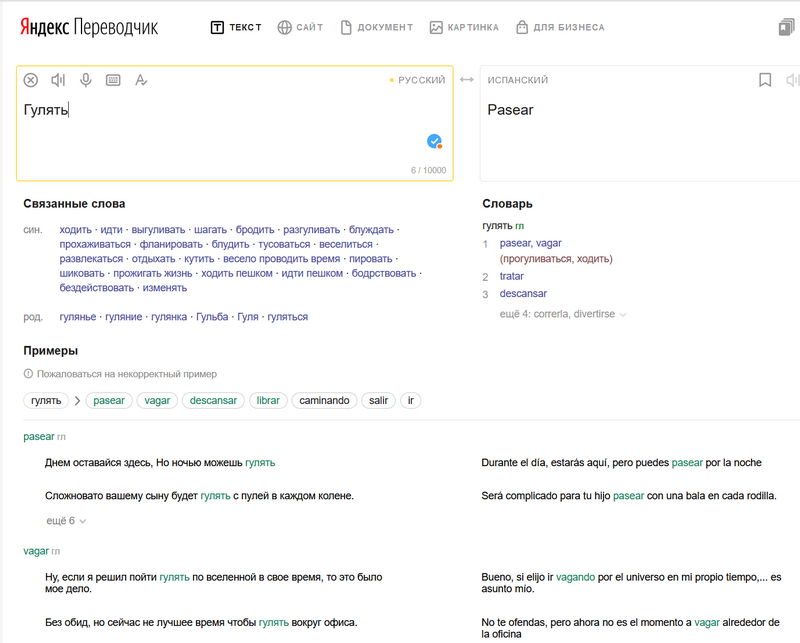

Кстати, что интересно, в моем личном рейтинг Яндекс.Переводчик обгоняет переводчик Google. Да-да, я много раз их сравнивал, и теперь пользуюсь практически только Яндекс.Переводчиком: он, на мой взгляд, более удобный и продвинутый. И дело не только в том, что ЯП определяет язык, на котором ты пишешь и автоматически меняет направление перевода, если это требуется. (Пример. В ЯП выставлен перевод с испанского на русский. Я в испанском разделе начинаю писать на русском - ЯП сам меняет направление перевода и правильно выдает результат.) А переводчик Google такое не умеет делать в упор.

Но у Яндекса также значительно разнообразнее связанные слова и намного разнообразнее реальные примеры употребления, что мне очень помогает.

Вот, сравните.

Остальные сервисы я обычно использую гугловские, особенно поиск. Но в плане автоматического перевода Яндекс тут лично у меня вырвался вперед, как ни странно.

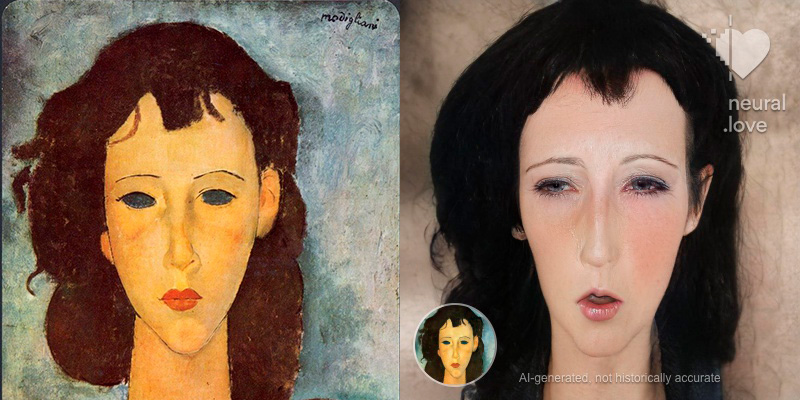

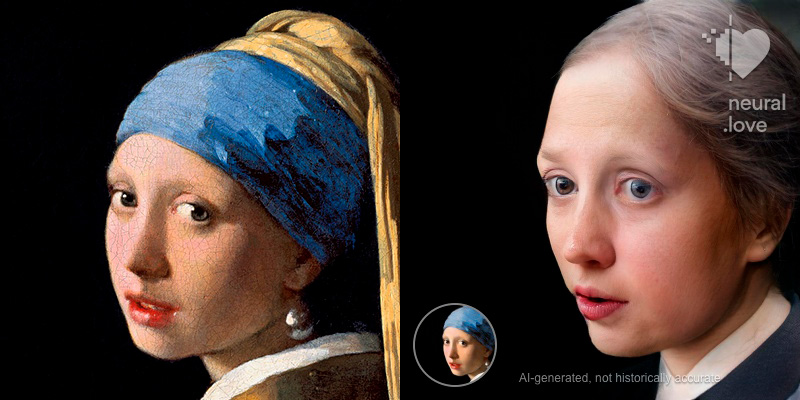

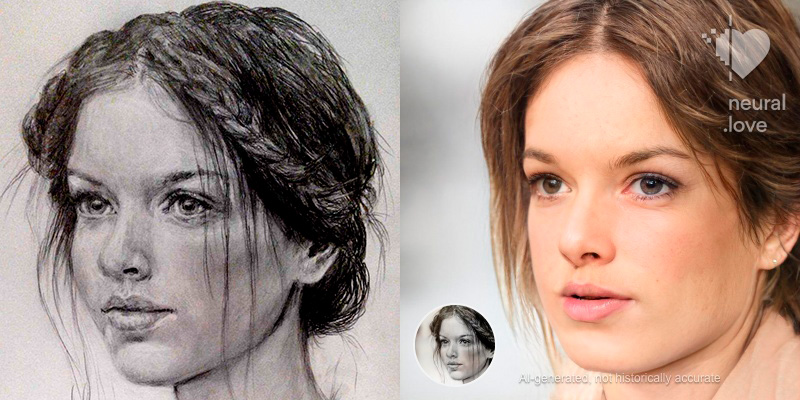

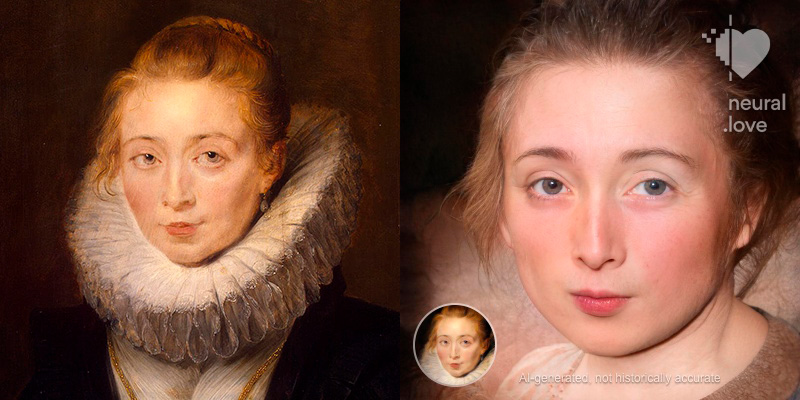

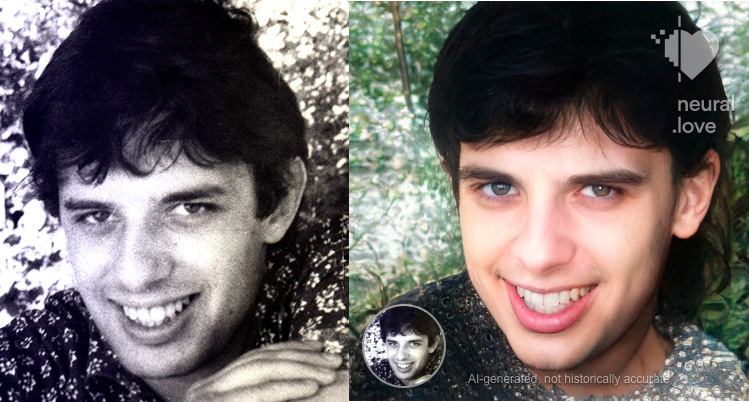

Сервис называется Neural.love. Нейросеть умеет обрабатывать фото и видео, делая реалистичными (как бы фото) рисунки и картинки. Также умеет раскрашивать черно-белые фото, но это не так интересно.

Вот пример фото.

Портреты и картинки - значительно интереснее.